1.

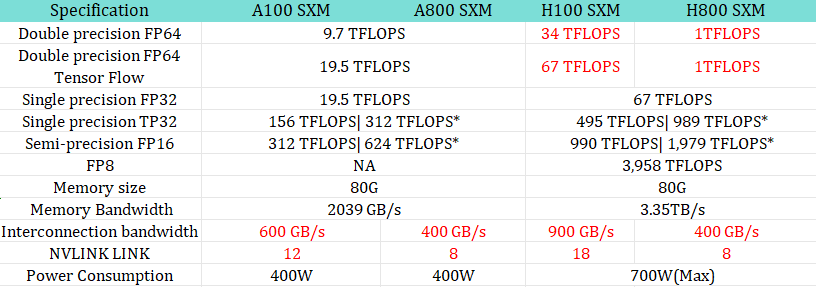

DeepSeek와 관련한 글을 읽으면서 이해도가 무척 떨어집니다. AI 기술에 대한 이해도 낮고 Nvidia GPU에 대한 이해도 낮습니다. 그래서 A100과 H800이 무엇인지, 어떻게 다른지도 잘 모릅니다. 엔비디아 AI 칩: A100 A800 H100 H800 B200에 올라온 비교표로 이해를 높혔습니다.우선….

Dropbox 부사장 Morgan Brown이 쓴 Why DeepSeek’s AI Breakthrough May Be the Most Crucial One Yet. linkedin에 올린 글입니다. AI Product 담담 부사장으로서의 견해입니다.

🔥 Why DeepSeek’s AI Breakthrough May Be the Most Crucial One Yet.

I finally had a chance to dive into DeepSeek’s recent r1 model innovations, and it’s hard to overstate the implications. This isn’t just a technical achievement – it’s democratization of AI technology.

Let me explain why this matters for everyone in tech, not just AI teams.

🎯 The Big Picture:

Traditional model development has been like building a skyscraper – you need massive resources, billions in funding, and years of work. DeepSeek just showed you can build the same thing for 5% of the cost, in a fraction of the time.Here’s what they achieved:

• Matched GPT-4 level performance

• Cut training costs from $100M+ to $5M

• Reduced GPU requirements by 98%

• Made models run on consumer hardware

• Released everything as open source🤔 Why This Matters:

1. For Business Leaders:

– model development & AI implementation costs could drop dramatically

– Smaller companies can now compete with tech giants

– ROI calculations for AI projects need complete revision

– Infrastructure planning can possibly be drastically simplified2. For Developers & Technical Teams:

– Advanced AI becomes accessible without massive compute

– Development cycles can be dramatically shortened

– Testing and iteration become much more feasible

– Open source access to state-of-the-art techniques3. For Product Managers:

– Features previously considered “too expensive” become viable

– Faster prototyping and development cycles

– More realistic budgets for AI implementation

– Better performance metrics for existing solutions💡 The Innovation Breakdown:

What makes this special isn’t just one breakthrough – it’s five clever innovations working together:• Smart number storage (reducing memory needs by 75%)

• Parallel processing improvements (2x speed increase)

• Efficient memory management (massive scale improvements)

• Better resource utilization (near 100% GPU efficiency)

• Specialist AI system (only using what’s needed, when needed)🌟 Real-World Impact:

Imagine running ChatGPT-level AI on your gaming computer instead of a data center. That’s not science fiction anymore – that’s what DeepSeek achieved.🔄 Industry Implications:

This could reshape the entire AI industry:

– Hardware manufacturers (looking at you, Nvidia) may need to rethink business models

– Cloud providers might need to revise their pricing

– Startups can now compete with tech giants

– Enterprise AI becomes much more accessible📈 What’s Next:

I expect we’ll see:

1. Rapid adoption of these techniques by major players

2. New startups leveraging this more efficient approach

3. Dropping costs for AI implementation

4. More innovative applications as barriers lower🎯 Key Takeaway:

The AI playing field is being leveled. What required billions and massive data centers might now be possible with a fraction of the resources. This isn’t just a technical achievement – it’s a democratization of AI technology.

한글로 정리한 글은 드롭박스 모건 브라운이 설명한 딥시크 그리고..에서 보실 수 있습니다. 트윗이나 threads를 통해 널리 옮겨지고 있기도 합니다.

1.먼저 배경부터 설명하겠습니다. 현재 최첨단 AI 모델을 훈련시키는 비용은 엄청나게 비쌉니다.OpenAI, Anthropic 같은 회사들은 계산에만 1억 달러 이상을 쓰며, $4만짜리 GPU 수천 대가 필요한 대규모 데이터 센터를 운영합니다. 마치 공장을 운영하기 위해 발전소 전체가 필요한 상황과 같습니다.

2.그런데 DeepSeek이 나타나서 이렇게 말했습니다.

“LOL, 우리라면 이걸 500만 달러로 할 수 있을걸?”

그리고 말로만 한 것이 아니라 실제로 해냈습니다.그들의 모델은 GPT-4와 Claude를 많은 작업에서 능가하거나 대등합니다. AI 업계는 (요즘 10대들이 말하듯) ‘충격’을 받았습니다.3.어떻게 가능했을까요?

그들은 모든 것을 처음부터 다시 생각했습니다.전통적인 AI는 마치 모든 숫자를 소수점 32자리까지 기록하는 것과 같습니다.DeepSeek은 “8자리로만 기록하면 어떨까? 충분히 정확하잖아!”라고 접근했고, 결과적으로 메모리 사용량이 75% 감소했습니다.4.그리고 그들의 “멀티 토큰” 시스템도 주목할 만합니다.일반적인 AI는 초등학생이 읽듯이 “The… cat… sat…”처럼 읽습니다.반면, DeepSeek은 문장 전체를 한 번에 읽습니다. 결과적으로 2배 더 빠르고 90% 수준의 정확도를 자랑합니다.수십억 개의 단어를 처리할 때, 이런 효율성은 매우 중요합니다.

5.하지만 진짜 기발한 점은 “전문가 시스템”을 구축했다는 것입니다.한 거대한 AI가 모든 것을 다 알도록 만드는 대신(예: 한 사람이 의사, 변호사, 엔지니어 역할을 모두 하는 것처럼), DeepSeek은 필요한 경우에만 전문가들을 호출하도록 설계했습니다.

6.기존 모델은 1.8조 개의 파라미터가 항상 활성화되어야 합니다.DeepSeek은 6710억 개의 파라미터 중 단지 370억 개만 활성화됩니다. 마치 큰 팀을 운영하되 필요한 전문가만 호출하는 것과 같습니다.

7.결과는 놀랍습니다:

• 훈련 비용: 1억 달러 → 500만 달러

• 필요한 GPU 수: 100,000대 → 2,000대

• API 비용: 95% 절감

• 데이터 센터 하드웨어 대신 게이밍 GPU에서도 실행 가능8.“그런데,” 누군가 말할 수 있습니다. “분명 단점이 있겠지!”놀라운 점은, 모든 것이 오픈 소스라는 것입니다. 누구나 그들의 작업을 검증할 수 있습니다. 코드는 공개되어 있고, 기술 논문은 모든 과정을 설명합니다. 마법이 아니라, 단순히 매우 영리한 엔지니어링입니다.

9.왜 중요한가요?

이로 인해 “대형 기술 기업만이 AI를 다룰 수 있다”는 기존의 모델이 깨졌습니다. 이제 수십억 달러 규모의 데이터 센터가 필요하지 않습니다. 좋은 GPU 몇 대만 있으면 됩니다.10.Nvidia에게는 두려운 이야기입니다.그들의 비즈니스 모델은 초고가 GPU를 90% 마진으로 판매하는 데 기반을 두고 있습니다. 하지만 모두가 일반 게이밍 GPU로 AI를 돌릴 수 있게 된다면… 문제는 명확합니다.

11. 그리고 중요한 점은 DeepSeek이 이를 200명 이하의 팀으로 해냈다는 것입니다. 한편 Meta의 팀은 DeepSeek 전체 훈련 예산보다 더 많은 연봉을 받으며 작업을 하고 있지만, 그들의 모델은 DeepSeek만큼 좋지 않습니다.

12.이는 전형적인 파괴적 혁신의 이야기입니다.

기존 기업들은 기존 프로세스를 최적화하는 데 초점을 맞추는 반면, 파괴적인 혁신 기업들은 근본적인 접근 방식을 다시 생각합니다.

DeepSeek은 “더 많은 하드웨어를 투입하기보다 더 똑똑하게 접근하면 어떨까?”라고 물었습니다.

13.그 영향은 큽니다:

• AI 개발이 더 접근 가능해짐

• 경쟁이 급격히 증가

• 대형 기술 기업들의 “진입 장벽”이 작은 웅덩이처럼 보임

• 하드웨어 요구 사항(및 비용)이 급감14.물론, OpenAI와 Anthropic 같은 대기업들이 가만히 있지는 않을 것입니다.그들은 아마도 이미 이러한 혁신을 구현하고 있을 것입니다.그러나 효율성의 램프는 이제 병 밖으로 나왔으며, “더 많은 GPU를 투입하자”라는 접근 방식으로 돌아갈 수는 없습니다.

15.마지막 생각:

이 순간은 우리가 나중에 변곡점으로 기억할 가능성이 높습니다.마치 PC가 메인프레임을 덜 중요하게 만들거나, 클라우드 컴퓨팅이 모든 것을 바꿨던 것처럼요.AI는 더 접근 가능하고, 훨씬 저렴해질 것입니다.이 변화가 현재 플레이어들에게 어떤 영향을 미칠지는 속도의 문제일 뿐입니다.

2.

페이스북을 통해 AI와 관련한 최신 연구논문을 소개하시는 최승준님이 DeepSeek논문을 번역해서 올려주셨습니다.

DeepSeek-R1: 강화 학습을 통한 대규모 언어 모델의 추론 능력 유도

요약

우리는 첫 번째 세대의 추론 모델인 DeepSeek-R1-Zero와 DeepSeek-R1을 소개합니다. 사전 단계로 감독된 세밀 조정(SFT) 없이 대규모 강화 학습(RL)을 통해 훈련된 DeepSeek-R1-Zero는 뛰어난 추론 능력을 보여줍니다. RL을 통해 DeepSeek-R1-Zero는 자연스럽게 강력하고 흥미로운 여러 추론 행동을 발현합니다. 그러나 가독성 저하와 언어 혼합 등의 문제에 직면하게 됩니다. 이러한 문제를 해결하고 추론 성능을 더욱 향상시키기 위해, 우리는 다단계 훈련과 RL 이전의 콜드 스타트 데이터를 통합한 DeepSeek-R1을 도입합니다. DeepSeek-R1은 추론 작업에서 OpenAI-o1-1217과 비교 가능한 성능을 달성합니다. 연구 커뮤니티를 지원하기 위해, 우리는 Qwen 및 Llama를 기반으로 DeepSeek-R1-Zero, DeepSeek-R1, 그리고 6개의 밀집 모델(1.5B, 7B, 8B, 14B, 32B, 70B)을 오픈 소스화합니다.

– AIME 2024 (Pass@1)

– Codeforces (Percentile)

– GPQA Diamond (Pass@1)

– MATH-500 (Pass@1)

– MMLU (Pass@1)

– SWE-bench Verified (Resolved)1. 서론

최근 몇 년 동안, 대규모 언어 모델(LLMs)은 급속한 반복과 진화를 거치고 있습니다 (Anthropic, 2024; Google, 2024; OpenAI, 2024a), 인공 일반 지능(AGI)에 대한 격차를 점점 줄여가고 있습니다.

최근, 사후 훈련이 전체 훈련 파이프라인의 중요한 구성 요소로 등장했습니다. 이는 추론 작업의 정확성을 향상시키고, 사회적 가치와 일치시키며, 사용자 선호에 적응하는 것으로 나타났으며, 사전 훈련에 비해 상대적으로 적은 계산 자원을 요구합니다. 추론 능력의 맥락에서, OpenAI의 o1(OpenAI, 2024b) 시리즈 모델은 추론 과정의 체인-오브-소트(Chain-of-Thought) 길이를 늘려 추론 시간 확장을 도입한 최초의 모델이었습니다. 이 접근법은 수학, 코딩, 과학적 추론과 같은 다양한 추론 작업에서 상당한 향상을 달성했습니다. 그러나 효과적인 테스트 시간 확장의 문제는 연구 커뮤니티에게 여전히 열려 있는 질문입니다. 몇몇 이전 연구들은 과정 기반 보상 모델(Lightman et al., 2023; Uesato et al., 2022; Wang et al., 2023), 강화 학습(Kumar et al., 2024), 그리고 몬테 카를로 트리 탐색과 빔 탐색과 같은 검색 알고리즘(Feng et al., 2024; Trinh et al., 2024; Xin et al., 2024)을 포함한 다양한 접근 방식을 탐구했습니다. 그러나 이러한 방법들 중 어느 것도 OpenAI의 o1 시리즈 모델과 비교할 만한 일반 추론 성능을 달성하지 못했습니다.

이 논문에서, 우리는 순수한 강화 학습(RL)을 사용하여 언어 모델의 추론 능력을 향상시키기 위한 첫 번째 단계를 밟습니다. 우리의 목표는 감독된 데이터 없이 LLM이 순수 RL 과정을 통해 자기 진화를 통해 추론 능력을 개발할 수 있는 잠재력을 탐구하는 것입니다. 구체적으로, 우리는 DeepSeek-V3-Base를 베이스 모델로 사용하고, GRPO(Shao et al., 2024)를 RL 프레임워크로 사용하여 모델의 추론 성능을 향상시킵니다. 훈련 중, DeepSeek-R1-Zero는 자연스럽게 강력하고 흥미로운 여러 추론 행동을 발현했습니다. 수천 번의 RL 단계를 거친 후, DeepSeek-R1-Zero는 추론 벤치마크에서 뛰어난 성능을 보여줍니다. 예를 들어, AIME 2024에서 pass@1 점수는 15.6%에서 71.0%로 증가했으며, 다수 투표를 통해 점수가 86.7%로 더욱 향상되어 OpenAI-o1-0912의 성능과 일치합니다.

그러나 DeepSeek-R1-Zero는 가독성 저하와 언어 혼합과 같은 문제에 직면하게 됩니다. 이러한 문제를 해결하고 추론 성능을 더욱 향상시키기 위해, 우리는 소량의 콜드 스타트 데이터와 다단계 훈련 파이프라인을 통합한 DeepSeek-R1을 도입합니다. 구체적으로, 우리는 DeepSeek-V3-Base 모델을 세밀 조정하기 위해 수천 개의 콜드 스타트 데이터를 수집하는 것으로 시작합니다. 그 후, DeepSeek-R1-Zero와 같은 추론 지향 RL을 수행합니다. RL 과정에서 수렴에 가까워질 때, 우리는 RL 체크포인트에서 거부 샘플링을 통해 새로운 SFT 데이터를 생성하고, 글쓰기, 사실 QA, 자기 인식과 같은 도메인에서 DeepSeek-V3의 감독된 데이터와 결합하여 DeepSeek-V3-Base 모델을 재훈련합니다. 새로운 데이터로 세밀 조정한 후, 체크포인트는 모든 시나리오의 프롬프트를 고려하여 추가 RL 과정을 거칩니다. 이러한 단계를 거친 후, 우리는 DeepSeek-R1로 지칭되는 체크포인트를 얻었으며, 이는 OpenAI-o1-1217과 동등한 성능을 달성합니다.

우리는 또한 DeepSeek-R1에서 작은 밀집 모델로의 증류를 탐구합니다. Qwen2.5-32B(Qwen, 2024b)를 베이스 모델로 사용하여, DeepSeek-R1에서 직접 증류하는 것은 RL을 적용하는 것보다 더 우수한 성능을 보입니다. 이는 더 큰 베이스 모델이 발견한 추론 패턴이 추론 능력 향상에 중요함을 보여줍니다. 우리는 증류된 Qwen과 Llama(Dubey et al., 2024) 시리즈를 오픈 소스화합니다. 특히, 우리의 증류된 14B 모델은 최첨단 오픈 소스 QwQ-32B-Preview(Qwen, 2024a)을 큰 폭으로 능가하며, 증류된 32B 및 70B 모델은 밀집 모델 중 추론 벤치마크에서 새로운 기록을 세웁니다.1.1. 기여도

사후 훈련: 베이스 모델에 대한 대규모 강화 학습

– 우리는 사전 단계로 감독된 세밀 조정(SFT)에 의존하지 않고 베이스 모델에 직접 강화 학습(RL)을 적용합니다. 이 접근법을 통해 모델은 복잡한 문제를 해결하기 위한 체인-오브-소트(CoT)를 탐색할 수 있으며, 그 결과 DeepSeek-R1-Zero가 개발되었습니다. DeepSeek-R1-Zero는 자기 검증, 반성, 긴 CoT 생성과 같은 능력을 보여주며, 이는 연구 커뮤니티에 중요한 이정표를 세웁니다. 특히, 이는 SFT 없이 순수하게 RL을 통해 LLM의 추론 능력을 유도할 수 있음을 검증한 최초의 공개 연구입니다. 이 돌파구는 향후 이 분야의 발전에 길을 열어줍니다.

– 우리는 DeepSeek-R1을 개발하기 위한 파이프라인을 소개합니다. 이 파이프라인은 향상된 추론 패턴을 발견하고 인간의 선호도에 맞추기 위한 두 단계의 RL과 모델의 추론 및 비추론 능력의 시드 역할을 하는 두 단계의 SFT를 통합합니다. 우리는 이 파이프라인이 더 나은 모델을 생성함으로써 산업에 기여할 것이라 믿습니다.

증류: 작은 모델도 강력할 수 있습니다

– 우리는 더 큰 모델의 추론 패턴을 작은 모델로 증류할 수 있음을 입증합니다. 이는 작은 모델에 RL을 적용하여 발견된 추론 패턴보다 더 나은 성능을 발휘합니다. 오픈 소스인 DeepSeek-R1과 그 API는 향후 연구 커뮤니티가 더 나은 작은 모델을 증류하는 데 도움이 될 것입니다.

– DeepSeek-R1이 생성한 추론 데이터를 사용하여 연구 커뮤니티에서 널리 사용되는 여러 밀집 모델을 세밀 조정했습니다. 평가 결과는 증류된 작은 밀집 모델들이 벤치마크에서 뛰어난 성능을 발휘함을 보여줍니다. 예를 들어, DeepSeek-R1-Distill-Qwen-7B는 AIME 2024에서 55.5%를 달성하여 QwQ-32B-Preview를 능가합니다. 또한, DeepSeek-R1-Distill-Qwen-32B는 AIME 2024에서 72.6%, MATH-500에서 94.3%, LiveCodeBench에서 57.2%를 기록하였습니다. 이러한 결과는 이전의 오픈 소스 모델들을 크게 능가하며, o1-mini와 비교해도 손색이 없습니다. 우리는 Qwen2.5와 Llama3 시리즈를 기반으로 한 증류된 1.5B, 7B, 8B, 14B, 32B, 70B 체크포인트를 커뮤니티에 오픈 소스화합니다.1.2. 평가 결과 요약

– 추론 작업:

1. DeepSeek-R1은 AIME 2024에서 Pass@1 점수 79.8%를 달성하여 OpenAI-o1-1217을 약간 능가했습니다. MATH-500에서는 97.3%라는 인상적인 점수를 기록하여 OpenAI-o1-1217과 동등한 성능을 보였으며, 다른 모델들보다 크게 뛰어났습니다.

2. 코딩 관련 작업에서는 DeepSeek-R1이 Codeforces에서 2,029 Elo 등급을 달성하여 경쟁 참가자의 96.3%를 능가하는 전문가 수준의 성능을 보여주었습니다. 엔지니어링 관련 작업에서는 DeepSeek-R1이 DeepSeek-V3보다 약간 더 나은 성능을 보여 실제 세계의 개발자 작업에 도움이 될 수 있습니다.

– 지식:

MMLU, MMLU-Pro, GPQA Diamond와 같은 벤치마크에서 DeepSeek-R1은 MMLU에서 90.8%, MMLU-Pro에서 84.0%, GPQA Diamond에서 71.5%의 뛰어난 점수를 기록하여 DeepSeek-V3를 크게 능가했습니다. 이러한 벤치마크에서 OpenAI-o1-1217보다는 약간 낮은 성능을 보였지만, 다른 폐쇄형 모델들을 능가하여 교육 작업에서의 경쟁 우위를 입증했습니다. 사실 기반 벤치마크인 SimpleQA에서는 DeepSeek-R1이 DeepSeek-V3를 능가하여 사실 기반 쿼리를 처리하는 능력을 보여주었습니다. 이 벤치마크에서도 OpenAI-o1은 DeepSeek-R1을 능가하는 유사한 추세를 보였습니다.

– 기타:

DeepSeek-R1은 창의적 글쓰기, 일반 질문 응답, 편집, 요약 등 다양한 작업에서도 뛰어난 성능을 발휘합니다. AlpacaEval 2.0에서 길이 조절 승률 87.6%, ArenaHard에서 승률 92.3%를 기록하여 비시험 지향적인 쿼리를 지능적으로 처리하는 강력한 능력을 보여줍니다. 또한, DeepSeek-R1은 긴 컨텍스트 이해가 필요한 작업에서도 뛰어난 성능을 보이며, 긴 컨텍스트 벤치마크에서 DeepSeek-V3를 상당히 능가했습니다.2. 접근 방법

2.1. 개요

이전 연구들은 모델 성능을 향상시키기 위해 대량의 감독 데이터를 크게 의존해왔습니다. 본 연구에서는 감독된 세밀 조정(SFT) 없이도 대규모 강화 학습(RL)을 통해 추론 능력을 크게 향상시킬 수 있음을 보여줍니다. 더욱이, 소량의 콜드 스타트 데이터를 포함함으로써 성능을 더욱 향상시킬 수 있습니다. 다음 섹션에서는 다음을 제시합니다: (1) SFT 데이터 없이 베이스 모델에 직접 RL을 적용한 DeepSeek-R1-Zero, (2) 수천 개의 긴 체인-오브-소트(CoT) 예제를 사용하여 세밀 조정된 체크포인트에서 RL을 시작하는 DeepSeek-R1, (3) DeepSeek-R1의 추론 능력을 작은 밀집 모델로 증류하는 방법.

2.2. DeepSeek-R1-Zero: 베이스 모델에 대한 강화 학습

강화 학습은 이전 연구들에서 추론 작업에서 상당한 효과를 입증했습니다 (Shao et al., 2024; Wang et al., 2023). 그러나 이러한 연구들은 감독 데이터에 크게 의존했으며, 이는 수집하는 데 시간이 많이 소요됩니다. 이 섹션에서는 순수한 강화 학습 과정을 통해 감독 데이터 없이 LLM이 추론 능력을 개발할 수 있는 잠재력을 탐구합니다. 먼저 우리의 강화 학습 알고리즘에 대한 간략한 개요를 제공한 후, 몇 가지 흥미로운 결과를 제시하며, 이는 연구 커뮤니티에 유용한 통찰을 제공할 것으로 기대합니다.2.2.1. 강화 학습 알고리즘

그룹 상대 정책 최적화(Group Relative Policy Optimization, GRPO)

RL의 훈련 비용을 절감하기 위해, 우리는 정책 모델과 동일한 크기의 비평가 모델을 생략하고 그룹 점수로부터 기준선을 추정하는 GRPO(Shao et al., 2024)를 채택합니다. 구체적으로, 각 질문에 대해 GRPO는 기존 정책에서 출력 그룹을 샘플링한 후, 다음 목표를 최대화하여 정책 모델를 최적화합니다:2.2.2. 보상 모델링

보상은 훈련 신호의 원천으로, RL의 최적화 방향을 결정합니다. DeepSeek-R1-Zero를 훈련하기 위해, 우리는 주로 두 가지 유형의 보상으로 구성된 규칙 기반 보상 시스템을 채택했습니다:

– 정확도 보상: 정확도 보상 모델은 응답이 올바른지 평가합니다. 예를 들어, 결정론적 결과를 갖는 수학 문제의 경우, 모델은 지정된 형식(예: 상자 안에 최종 답)을 제공해야 하며, 이를 통해 올바름을 신뢰할 수 있는 규칙 기반으로 검증할 수 있습니다. 유사하게, LeetCode 문제의 경우, 컴파일러를 사용하여 사전 정의된 테스트 케이스에 기반한 피드백을 생성할 수 있습니다.

– 형식 보상: 정확도 보상 모델 외에도, 우리는 모델이 사고 과정을 ”와 ” 태그 사이에 두도록 강제하는 형식 보상 모델을 사용합니다.

우리는 DeepSeek-R1-Zero를 개발할 때 결과나 과정 신경망 보상 모델을 적용하지 않았습니다. 그 이유는 신경망 보상 모델이 대규모 강화 학습 과정에서 보상 해킹의 문제가 발생할 수 있으며, 보상 모델을 재훈련하는 데 추가적인 훈련 자원이 필요하고 전체 훈련 파이프라인을 복잡하게 만들기 때문입니다.2.2.3. 훈련 템플릿

DeepSeek-R1-Zero를 훈련하기 위해, 저희는 기본 모델이 주어진 지침을 따를 수 있도록 유도하는 간단한 템플릿을 설계하는 것부터 시작합니다. Table 1에서 볼 수 있듯이, 이 템플릿은 DeepSeek-R1-Zero가 먼저 추론 과정을 생성한 후 최종 답변을 도출하도록 요구합니다. 저희는 의도적으로 이러한 구조적 형식에 대한 제한만을 두고, 반성적 사고를 필수적으로 요구하거나 특정 문제 해결 전략을 장려하는 등의 내용적인 편향을 배제하였습니다. 이를 통해 강화 학습(RL) 과정에서 모델이 자연스럽게 발전하는 모습을 정확하게 관찰할 수 있도록 하였습니다.2.2.4. DeepSeek-R1-Zero의 성능, 자기 진화 과정 및 아하 순간

그림 2는 강화 학습(RL) 훈련 과정 전반에 걸쳐 AIME 2024 벤치마크에서 DeepSeek-R1-Zero의 성능 궤적을 보여줍니다. 그림에서 볼 수 있듯이, DeepSeek-R1-Zero는 RL 훈련이 진행됨에 따라 성능이 꾸준하고 지속적으로 향상되는 모습을 보입니다. 특히, AIME 2024에서의 평균 pass@1 점수가 초기 15.6%에서 인상적인 71.0%로 크게 증가하여 OpenAI-o1-0912와 유사한 성능 수준에 도달한 것이 주목할 만합니다. 이러한 상당한 개선은 시간이 지남에 따라 모델의 성능을 최적화하는 우리의 RL 알고리즘의 효율성을 강조합니다.

표 2는 다양한 추론 관련 벤치마크에서 DeepSeek-R1-Zero와 OpenAI의 o1-0912 모델을 비교 분석한 것입니다.

표 2 | DeepSeek-R1-Zero와 OpenAI o1 모델의 추론 관련 벤치마크 비교

그림 2 | 훈련 중 DeepSeek-R1-Zero의 AIME 정확도. 각 질문에 대해 16개의 응답을 샘플링하고 전체 평균 정확도를 계산하여 안정적인 평가를 보장합니다.

DeepSeek-R1-Zero는 지도 미세 조정 데이터 없이도 강력한 추론 능력을 획득할 수 있습니다. 이는 RL만으로도 모델이 효과적으로 학습하고 일반화할 수 있는 능력을 강조하는 주목할 만한 성과입니다. 또한, DeepSeek-R1-Zero의 성능은 다수결 투표 방식을 적용함으로써 더욱 향상될 수 있습니다. 예를 들어, AIME 벤치마크에서 다수결 투표를 적용하면 DeepSeek-R1-Zero의 성능이 71.0%에서 86.7%로 상승하여 OpenAI-o1-0912의 성능을 능가하게 됩니다. 다수결 투표의 유무에 관계없이 DeepSeek-R1-Zero가 이러한 경쟁력 있는 성능을 달성할 수 있다는 것은 모델의 강력한 기초 능력과 추론 과제에서의 추가 발전 가능성을 강조합니다.DeepSeek-R1-Zero의 자기 진화 과정

DeepSeek-R1-Zero의 자기 진화 과정은 RL이 모델의 추론 능력을 자율적으로 향상시키는 방법을 보여주는 흥미로운 사례입니다. RL을 기본 모델에서 직접 시작함으로써, 지도 미세 조정 단계의 영향을 받지 않고 모델의 진행 상황을 면밀히 모니터링할 수 있습니다. 이 접근 방식은 모델이 시간이 지남에 따라 특히 복잡한 추론 과제를 처리하는 능력 측면에서 어떻게 진화하는지 명확하게 보여줍니다.

그림 3에 나타난 바와 같이, DeepSeek-R1-Zero의 사고 시간은 훈련 과정 전반에 걸쳐 꾸준히 증가하고 있습니다. 이 향상은 외부 조정의 결과가 아니라 모델 내에서의 본질적인 발전입니다. DeepSeek-R1-Zero는 테스트 시점의 계산을 확장함으로써 점점 더 복잡한 추론 과제를 해결할 수 있는 능력을 자연스럽게 습득합니다. 이 계산은 수백에서 수천 개의 추론 토큰을 생성하는 것을 포함하여, 모델이 사고 과정을 더 깊이 탐구하고 정제할 수 있도록 합니다.

이 자기 진화의 가장 주목할 만한 측면 중 하나는 테스트 시점의 계산이 증가함에 따라 정교한 행동이 나타난다는 점입니다. 예를 들어, 모델이 이전 단계를 재검토하고 재평가하는 반성(reflection)이나 문제 해결을 위한 대체 접근 방식을 탐구하는 행동 등이 자발적으로 나타납니다. 이러한 행동은 명시적으로 프로그래밍된 것이 아니라, 모델이 강화 학습 환경과 상호 작용한 결과로 나타납니다. 이러한 자발적인 발전은 DeepSeek-R1-Zero의 추론 능력을 크게 향상시켜, 더 도전적인 과제를 더 효율적이고 정확하게 해결할 수 있게 합니다.DeepSeek-R1-Zero의 아하 순간

DeepSeek-R1-Zero의 훈련 중에 관찰된 특히 흥미로운 현상 중 하나는 “아하 순간”의 발생입니다. 표 3에 나타난 바와 같이, 이 순간은 모델의 중간 버전에서 발생합니다. 이 단계에서 DeepSeek-R1-Zero는 초기 접근 방식을 재평가함으로써 문제에 더 많은 사고 시간을 할당하는 방법을 학습합니다. 이 행동은 모델의 향상된 추론 능력을 증명할 뿐만 아니라, 강화 학습이 어떻게 예상치 못한 정교한 결과를 이끌어낼 수 있는지 보여주는 매혹적인 예입니다.

이 순간은 모델뿐만 아니라 그 행동을 관찰하는 연구자들에게도 “아하 순간”입니다. 이는 강화 학습의 힘과 아름다움을 강조합니다: 문제 해결 방법을 명시적으로 가르치는 대신, 적절한 인센티브를 제공함으로써 모델이 자율적으로 고급 문제 해결 전략을 개발하게 됩니다. “아하 순간”은 RL이 인공지능 시스템의 새로운 수준의 지능을 열어줄 잠재력을 강력하게 상기시켜주며, 미래에 더 자율적이고 적응력 있는 모델의 길을 닦아줍니다.

표 3 | DeepSeek-R1-Zero의 중간 버전에서 나타난 흥미로운 “아하 순간” 모델이 인간 친화적인 어조를 사용하여 재고하는 방법을 학습합니다. 이는 우리에게도 “아하 순간”으로, 강화 학습의 힘과 아름다움을 목격할 수 있게 해줍니다.DeepSeek-R1-Zero의 단점

DeepSeek-R1-Zero는 강력한 추론 능력을 발휘하고 자율적으로 예상치 못한 강력한 추론 행동을 개발하지만, 몇 가지 문제점에 직면해 있습니다. 예를 들어, DeepSeek-R1-Zero는 가독성이 떨어지거나 언어가 혼합되는 등의 문제를 겪고 있습니다. 추론 과정을 더 읽기 쉽게 만들고 이를 공개 커뮤니티와 공유하기 위해, 우리는 인간 친화적인 초기 데이터를 활용한 RL 방법인 DeepSeek-R1을 탐구합니다.2.3. DeepSeek-R1: 초기 데이터를 활용한 강화 학습

DeepSeek-R1-Zero의 유망한 결과에 영감을 받아 두 가지 자연스러운 질문이 제기됩니다: 1) 소량의 고품질 데이터를 초기 단계로 포함함으로써 추론 성능을 더욱 향상시키거나 수렴 속도를 가속화할 수 있는가? 2) 명확하고 일관된 사고의 사슬(CoT)을 생성할 뿐만 아니라 강력한 일반 능력을 보여주는 사용자 친화적인 모델을 어떻게 훈련시킬 수 있는가? 이러한 질문에 답하기 위해, 우리는 DeepSeek-R1을 훈련시키기 위한 파이프라인을 설계했습니다. 이 파이프라인은 다음과 같이 네 단계로 구성됩니다.2.3.1. 초기 시작 (Cold Start)

DeepSeek-R1-Zero와 달리, 기본 모델에서 RL 훈련의 초기 불안정한 초기 시작 단계를 방지하기 위해, DeepSeek-R1에서는 소량의 긴 사고의 사슬(CoT) 데이터를 구성하고 수집하여 초기 RL 액터로서 모델을 미세 조정합니다. 이러한 데이터를 수집하기 위해 몇 가지 접근 방식을 탐구했습니다: 긴 CoT를 예제로 사용하는 몇 샷 프롬프트, 반성과 검증을 포함한 상세한 답변을 생성하도록 모델을 직접 프롬프트, 읽기 쉬운 형식으로 DeepSeek-R1-Zero의 출력을 수집, 그리고 인간 주석자가 후처리를 통해 결과를 정제하는 방법 등이 있습니다.

본 연구에서는 약 수천 개의 초기 시작 데이터를 수집하여 RL의 시작점으로 DeepSeek-V3-Base를 미세 조정했습니다. DeepSeek-R1-Zero와 비교할 때, 초기 시작 데이터의 장점은 다음과 같습니다:– 가독성: DeepSeek-R1-Zero의 주요 한계는 그 내용이 종종 읽기에 적합하지 않다는 점입니다. 응답이 여러 언어를 혼합하거나 사용자를 위한 답변을 강조하기 위한 마크다운 형식이 부족할 수 있습니다. 반면, DeepSeek-R1을 위한 초기 시작 데이터를 생성할 때는 각 응답 끝에 요약을 포함하는 읽기 쉬운 패턴을 설계하고, 읽기 불편한 응답은 필터링합니다. 여기서 출력 형식을 ‘|special_token||special_token|

‘로 정의하며, reasoning_process는 질의에 대한 CoT이고, summary는 추론 결과를 요약하는 데 사용됩니다.

– 잠재력: 인간의 사전 지식을 반영하여 초기 시작 데이터의 패턴을 신중하게 설계함으로써 DeepSeek-R1-Zero에 비해 더 나은 성능을 관찰했습니다. 우리는 반복적인 훈련이 추론 모델에 더 나은 방법이라고 믿습니다.2.3.2. 추론 지향 강화 학습 (Reasoning-oriented Reinforcement Learning)

DeepSeek-V3-Base를 초기 시작 데이터로 미세 조정한 후, DeepSeek-R1-Zero에서 사용된 것과 동일한 대규모 강화 학습 훈련 과정을 적용합니다. 이 단계는 특히 코딩, 수학, 과학, 논리적 추론과 같은 명확한 해결책이 있는 잘 정의된 문제를 포함하는 추론 집약적 과제에서 모델의 추론 능력을 향상시키는 데 중점을 둡니다. 훈련 과정에서 CoT가 종종 여러 언어를 혼합하는 경향을 보이는 것을 관찰했습니다. 특히 RL 프롬프트가 여러 언어를 포함할 때 이러한 문제가 두드러졌습니다. 이 문제를 완화하기 위해, RL 훈련 중 언어 일관성 보상을 도입했습니다. 이는 CoT에서 대상 언어 단어의 비율로 계산됩니다. 절제 실험(ablation experiments) 결과, 이러한 정렬은 모델의 성능에 약간의 저하를 초래하지만, 이는 인간의 선호와 일치하여 가독성을 높입니다. 마지막으로, 우리는 추론 과제의 정확도와 언어 일관성 보상을 직접 합산하여 최종 보상을 형성합니다. 그런 다음, 모델이 추론 과제에서 수렴할 때까지 미세 조정된 모델에 대해 강화 학습(RL) 훈련을 적용합니다.2.3.3. 거부 샘플링 및 지도 미세 조정 (Rejection Sampling and Supervised Fine-Tuning)

추론 지향 RL이 수렴하면, 결과로 나온 체크포인트를 사용하여 이후 라운드를 위한 SFT(Supervised Fine-Tuning) 데이터를 수집합니다. 초기 초기 시작 데이터가 주로 추론에 초점을 맞춘 반면, 이 단계에서는 글쓰기, 역할 연기, 기타 일반 목적 과제에서 모델의 능력을 향상시키기 위해 다른 도메인의 데이터를 포함합니다. 구체적으로, 우리는 데이터를 생성하고 아래에 설명된 대로 모델을 미세 조정합니다.

– 추론 데이터: 추론 프롬프트를 선별하고, 위의 RL 훈련 체크포인트에서 거부 샘플링을 수행하여 추론 궤적을 생성합니다. 이전 단계에서는 주로 규칙 기반 보상을 사용하여 평가할 수 있는 데이터만 포함했습니다. 그러나 이 단계에서는 일부 데이터를 생성 보상 모델을 사용하여 확장합니다. 이는 DeepSeek-V3에 실제 정답과 모델 예측을 입력하여 판단하게 하는 방식입니다. 또한, 모델 출력이 때때로 혼란스럽고 읽기 어려운 경우가 있어, 혼합 언어, 긴 단락, 코드 블록이 포함된 사고의 사슬을 필터링했습니다. 각 프롬프트에 대해 여러 응답을 샘플링하고 올바른 응답만 유지했습니다. 총 약 60만 개의 추론 관련 훈련 샘플을 수집했습니다.

– 비추론 데이터: 글쓰기, 사실 기반 QA, 자기 인식, 번역과 같은 비추론 데이터의 경우, DeepSeek-V3 파이프라인을 채택하고 DeepSeek-V3의 SFT 데이터셋 일부를 재사용합니다. 특정 비추론 과제에 대해, 우리는 질문에 답변하기 전에 잠재적인 사고의 사슬(CoT)을 생성하도록 DeepSeek-V3를 호출합니다. 그러나 “안녕하세요”와 같은 간단한 질의에는 CoT를 제공하지 않습니다. 최종적으로, 추론과 관련 없는 약 20만 개의 훈련 샘플을 수집했습니다.

우리는 약 80만 개의 샘플로 구성된 위에서 선별된 데이터셋을 사용하여 DeepSeek-V3-Base를 두 번의 에포크 동안 미세 조정했습니다.2.3.4. 모든 시나리오를 위한 강화 학습 (Reinforcement Learning for all Scenarios)

모델을 인간의 선호에 더욱 맞추기 위해, 모델의 유용성과 무해성을 향상시키는 동시에 추론 능력을 다듬는 2차 강화 학습 단계를 구현했습니다. 구체적으로, 우리는 보상 신호와 다양한 프롬프트 분포의 조합을 사용하여 모델을 훈련시킵니다. 추론 데이터의 경우, 수학, 코드, 논리적 추론 도메인에서 학습 과정을 안내하기 위해 규칙 기반 보상을 사용하는 DeepSeek-R1-Zero에서 설명한 방법론을 준수합니다. 일반 데이터의 경우, 복잡하고 미묘한 시나리오에서 인간의 선호를 포착하기 위해 보상 모델을 사용합니다. 우리는 DeepSeek-V3 파이프라인을 기반으로 선호 쌍과 훈련 프롬프트의 유사한 분포를 채택합니다. 유용성에 대해서는 최종 요약에만 집중하여, 응답의 유용성과 관련성을 강조하면서 기본 추론 과정에 대한 간섭을 최소화합니다. 무해성에 대해서는, 추론 과정과 요약을 모두 포함한 모델의 전체 응답을 평가하여, 생성 과정에서 발생할 수 있는 잠재적 위험, 편향 또는 유해한 내용을 식별하고 완화합니다. 궁극적으로, 보상 신호와 다양한 데이터 분포의 통합은 추론에 탁월하면서도 유용성과 무해성을 우선시하는 모델을 훈련할 수 있게 합니다.2.4. 증류: 작은 모델에 추론 능력 부여 (Distillation: Empower Small Models with Reasoning Capability)

더 효율적인 작은 모델들에게 DeepSeek-R1과 같은 추론 능력을 부여하기 위해, 우리는 Qwen(Qwen, 2024b)과 Llama(AI@Meta, 2024)와 같은 오픈 소스 모델을 DeepSeek-R1에서 선별된 80만 개의 샘플을 사용하여 직접 미세 조정했습니다(§2.3.3에 자세히 설명됨). 우리의 발견에 따르면, 이 단순한 증류 방법은 작은 모델의 추론 능력을 크게 향상시킵니다. 여기서 사용한 기본 모델은 Qwen2.5-Math-1.5B, Qwen2.5-Math-7B, Qwen2.5-14B, Qwen2.5-32B, Llama-3.1-8B, 및 Llama-3.3-70B-Instruct입니다. 우리는 Llama-3.3의 추론 능력이 Llama-3.1보다 약간 더 우수하기 때문에 이를 선택했습니다.

증류된 모델의 경우, RL 단계를 포함하지 않고 SFT만 적용했습니다. 이는 RL을 포함하면 모델 성능이 크게 향상될 수 있지만, 우리의 주요 목표는 증류 기술의 효과를 입증하는 것이며, RL 단계의 탐색은 더 넓은 연구 커뮤니티에 맡기기 위함입니다.3. 실험 (Experiment)

벤치마크

우리는 MMLU(Hendrycks et al., 2020), MMLU-Redux(Gema et al., 2024), MMLU-Pro(Wang et al., 2024), C-Eval(Huang et al., 2023), CMMLU(Li et al., 2023), IFEval(Zhou et al., 2023), FRAMES(Krishna et al., 2024), GPQA Diamond(Rein et al., 2023), SimpleQA(OpenAI, 2024c), C-SimpleQA(He et al., 2024), SWE-Bench Verified(OpenAI, 2024d), Aider 1, LiveCodeBench(Jain et al., 2024) (2024-08 – 2025-01), Codeforces 2, 중국 국가 고등학교 수학 올림피아드(CNMO 2024)3, 및 American Invitational Mathematics Examination 2024 (AIME 2024)(MAA, 2024)에서 모델을 평가했습니다. 표준 벤치마크 외에도, 우리는 LLM을 심사위원으로 사용하여 개방형 생성 과제를 평가했습니다. 구체적으로, 우리는 AlpacaEval 2.0(Dubois et al., 2024)과 Arena-Hard(Li et al., 2024)의 원래 구성을 준수하며, 이는 쌍별 비교를 위해 GPT-4-Turbo-1106을 심사위원으로 활용합니다. 여기서는 길이 편향을 피하기 위해 최종 요약만 평가에 제공합니다. 증류된 모델의 경우, AIME 2024, MATH-500, GPQA Diamond, Codeforces, 및 LiveCodeBench에서 대표적인 결과를 보고합니다.

평가 프롬프트

DeepSeek-V3에서 설정한 대로, MMLU, DROP, GPQA Diamond, 및 SimpleQA와 같은 표준 벤치마크는 simple-evals 프레임워크의 프롬프트를 사용하여 평가됩니다. MMLU-Redux의 경우, zero-shot 설정에서 Zero-Eval 프롬프트 형식(Lin, 2024)을 채택했습니다. MMLU-Pro, C-Eval 및 CLUE-WSC의 경우, 원래 프롬프트가 몇 샷이므로 이를 약간 수정하여 zero-shot 설정으로 변경했습니다. few-shot의 CoT는 DeepSeek-R1의 성능을 저하시킬 수 있습니다. 다른 데이터셋은 생성자에 의해 제공된 기본 프롬프트로 원래 평가 프로토콜을 따릅니다. 코드 및 수학 벤치마크의 경우, HumanEval-Mul 데이터셋은 여덟 가지 주류 프로그래밍 언어(Python, Java, C++, C#, JavaScript, TypeScript, PHP, 및 Bash)를 다룹니다. LiveCodeBench의 모델 성능은 CoT 형식을 사용하여 평가되며, 2024년 8월부터 2025년 1월까지 수집된 데이터를 사용합니다. Codeforces 데이터셋은 10개의 Div.2 대회 문제와 전문가가 제작한 테스트 케이스를 사용하여 평가되며, 이후 예상 등급과 경쟁자의 비율을 계산합니다. SWE-Bench 검증 결과는 agentless 프레임워크(Xia et al., 2024)를 통해 얻었습니다. AIDER 관련 벤치마크는 “diff” 형식을 사용하여 측정했습니다. DeepSeek-R1 출력은 각 벤치마크당 최대 32,768 토큰으로 제한됩니다.기준 모델 (Baselines)

우리는 DeepSeek-V3, Claude-Sonnet-3.5-1022, GPT-4o-0513, OpenAI-o1-mini, 및 OpenAI-o1-1217을 포함한 여러 강력한 기준 모델과 비교 평가를 수행했습니다. 중국 본토에서 OpenAI-o1-1217 API에 접근하기 어려워, 공식 보고서를 기반으로 그 성능을 보고했습니다. 증류된 모델의 경우, 오픈 소스 모델인 QwQ-32B-Preview(Qwen, 2024a)와도 비교했습니다.생성 설정 (Generation Setup)

모든 모델에 대해 최대 생성 길이는 32,768 토큰으로 설정했습니다. 샘플링이 필요한 벤치마크의 경우, 온도는 0.6, top-p 값은 0.95로 설정하고, pass@1을 추정하기 위해 각 질의당 64개의 응답을 생성했습니다.3.1. DeepSeek-R1 평가

MMLU, MMLU-Pro, 및 GPQA Diamond와 같은 교육 지향 지식 벤치마크에서 DeepSeek-R1은 DeepSeek-V3보다 우수한 성능을 보였습니다. 이러한 향상은 주로 STEM 관련 질문의 정확도 향상에 기인하며, 대규모 강화 학습(RL)을 통해 상당한 이득을 얻었습니다. 또한, DeepSeek-R1은 FRAMES와 같은 장기 문맥 의존 QA 과제에서도 뛰어난 성능을 보여, 문서 분석 능력이 강함을 입증했습니다. 이는 AI 기반 검색 및 데이터 분석 과제에서 추론 모델의 잠재력을 강조합니다. 사실 기반 벤치마크인 SimpleQA에서는 DeepSeek-R1이 DeepSeek-V3보다 우수한 성능을 보였으며, 이는 사실 기반 질의를 처리하는 능력을 나타냅니다. 유사한 추세가 OpenAI-o1이 GPT-4o를 이 벤치마크에서 능가하는 것에서도 관찰됩니다. 그러나 DeepSeek-R1은 안전 RL 후 특정 질의에 대한 응답을 거부하는 경향 때문에 중국 SimpleQA 벤치마크에서는 DeepSeek-V3보다 성능이 떨어집니다. 안전 RL 없이 DeepSeek-R1은 70% 이상의 정확도를 달성할 수 있었습니다.

DeepSeek-R1은 형식 지시를 따르는 모델의 능력을 평가하기 위한 벤치마크인 IF-Eval에서도 인상적인 결과를 보였습니다. 이러한 향상은 지도 미세 조정(SFT) 및 RL 훈련의 마지막 단계에서 지시 따르기 데이터를 포함한 것과 관련이 있습니다. 또한, AlpacaEval2.0과 ArenaHard에서도 주목할 만한 성능을 보이며, DeepSeek-R1의 글쓰기 과제 및 개방형 도메인 질문 응답에서의 강점을 나타냈습니다. DeepSeek-R1이 DeepSeek-V3를 크게 능가하는 것은 대규모 RL의 일반화 이점, 즉 추론 능력을 향상시킬 뿐만 아니라 다양한 도메인에서의 성능을 개선함을 강조합니다. 더욱이, DeepSeek-R1이 생성한 요약 길이는 간결하며, ArenaHard에서는 평균 689 토큰, AlpacaEval 2.0에서는 2,218자로 GPT 기반 평가 중 길이 편향을 도입하지 않음을 나타내어 다양한 과제에서의 견고함을 더욱 강화합니다.

수학 과제에서는 DeepSeek-R1이 OpenAI-o1-1217과 동등한 성능을 보이며 다른 모델들을 크게 능가했습니다. LiveCodeBench와 Codeforces와 같은 코딩 알고리즘 과제에서도 유사한 추세가 나타나, 추론 중심 모델이 이러한 벤치마크를 지배했습니다. 공학 지향 코딩 과제에서는 OpenAI-o1-1217이 Aider에서 DeepSeek-R1을 능가했지만, SWE Verified에서는 비슷한 성능을 보였습니다. 우리는 관련 RL 훈련 데이터의 양이 현재 매우 제한적이기 때문에 DeepSeek-R1의 공학 성능이 다음 버전에서 향상될 것으로 믿습니다.3.2. 증류된 모델 평가 (Distilled Model Evaluation)

표 5에서 볼 수 있듯이, 단순히 DeepSeek-R1의 출력을 증류함으로써, 효율적인 DeepSeek-R1-7B(즉, DeepSeek-R1-Distill-Qwen-7B)는 모든 측면에서 GPT-4o-0513과 같은 비추론 모델을 능가할 수 있습니다. DeepSeek-R1-14B는 모든 평가 지표에서 QwQ-32B-Preview를 능가했으며, DeepSeek-R1-32B 및 DeepSeek-R1-70B는 대부분의 벤치마크에서 o1-mini를 크게 초과했습니다. 이러한 결과는 증류의 강력한 잠재력을 보여줍니다. 또한, 이러한 증류된 모델에 RL을 적용하면 상당한 추가 향상이 이루어짐을 발견했습니다. 우리는 이것이 더 많은 탐색을 필요로 한다고 믿으며, 여기서는 단순한 SFT-증류된 모델의 결과만을 제시합니다.4. 논의 (Discussion)

4.1. 증류 vs. 강화 학습 (Distillation vs. Reinforcement Learning)

표 6에서 볼 수 있듯이, DeepSeek-R1을 증류함으로써 작은 모델이 인상적인 결과를 달성할 수 있습니다. 그러나 여전히 하나의 질문이 남습니다: 증류 없이 본 논문에서 논의된 대규모 RL 훈련을 통해 모델이 동등한 성능을 달성할 수 있을까요?

이 질문에 답하기 위해, 우리는 Qwen-32B-Base에 대해 수학, 코드, STEM 데이터를 사용하여 10K 스텝 이상 대규모 RL 훈련을 수행했고, 그 결과 DeepSeek-R1-Zero-Qwen-32B를 얻었습니다. 그림 6에 나타난 실험 결과는, 32B 기본 모델이 대규모 RL 훈련 후 QwQ-32B-Preview와 동등한 성능을 달성함을 보여줍니다. 그러나 DeepSeek-R1에서 증류된 DeepSeek-R1-Distill-Qwen-32B는 모든 벤치마크에서 DeepSeek-R1-Zero-Qwen-32B보다 현저히 우수한 성능을 보입니다. 따라서 두 가지 결론을 도출할 수 있습니다: 첫째, 더 강력한 모델을 작은 모델로 증류하는 것은 우수한 결과를 산출하지만, 본 논문에서 언급한 대규모 RL에 의존하는 작은 모델은 막대한 계산력을 필요로 하며 증류의 성능에 미치지 못할 수 있습니다. 둘째, 증류 전략은 경제적이고 효과적이지만, 지능의 경계를 넘어서는 것은 여전히 더 강력한 기본 모델과 대규모 강화 학습을 필요로 할 수 있습니다.4.2. 실패한 시도 (Unsuccessful Attempts)

DeepSeek-R1을 개발하는 초기 단계에서, 우리는 실패와 좌절을 겪기도 했습니다. 여기서는 이러한 실패 경험을 공유하여 통찰을 제공하고자 하지만, 이는 이러한 접근 방식이 효과적인 추론 모델을 개발할 수 없음을 의미하지는 않습니다.

– 프로세스 보상 모델 (Process Reward Model, PRM): PRM은 모델을 더 나은 추론 접근 방식으로 이끄는 합리적인 방법입니다(Lightman et al., 2023; Uesato et al., 2022; Wang et al., 2023). 그러나 실제로 PRM에는 세 가지 주요 한계가 있어 궁극적인 성공을 저해할 수 있습니다. 첫째, 일반 추론에서 세분화된 단계를 명시적으로 정의하기 어렵습니다. 둘째, 현재 중간 단계가 올바른지 여부를 결정하는 것이 어려운 과제입니다. 모델을 사용한 자동 주석은 만족스러운 결과를 내지 못할 수 있으며, 수동 주석은 확장을 방해합니다. 셋째, 모델 기반 PRM을 도입하면 보상 해킹(Gao et al., 2022)이 불가피하게 발생하며, 보상 모델을 재훈련하는 데 추가적인 훈련 자원이 필요하고 전체 훈련 파이프라인을 복잡하게 만듭니다. 결론적으로, PRM은 모델이 생성한 상위-N 응답을 재정렬하거나 안내된 검색을 지원하는 데 좋은 능력을 보이지만(Snell et al., 2024), 우리의 실험에서 대규모 강화 학습 과정 중 추가적인 계산 오버헤드에 비해 그 이점은 제한적입니다.

– 몬테 카를로 트리 탐색 (Monte Carlo Tree Search, MCTS): AlphaGo(Silver et al., 2017b) 및 AlphaZero(Silver et al., 2017a)에 영감을 받아, 우리는 테스트 시점의 계산 확장성을 향상시키기 위해 몬테 카를로 트리 탐색(MCTS)을 사용하는 것을 탐구했습니다. 이 접근 방식은 답변을 더 작은 부분으로 나누어 모델이 체계적으로 해결 공간을 탐색할 수 있도록 합니다. 이를 촉진하기 위해, 우리는 모델에게 검색에 필요한 특정 추론 단계를 나타내는 여러 태그를 생성하도록 프롬프트합니다. 훈련을 위해, 먼저 수집된 프롬프트를 사용하여 사전 훈련된 가치 모델에 의해 안내된 MCTS를 통해 답변을 찾습니다. 그 후, 결과로 나온 질문-답변 쌍을 사용하여 액터 모델과 가치 모델을 모두 훈련시키고, 과정을 반복적으로 개선합니다.

그러나 이 접근 방식은 훈련을 확장할 때 여러 가지 도전에 직면합니다. 첫째, 체스와 달리 검색 공간이 상대적으로 잘 정의되지 않은 토큰 생성은 지수적으로 더 큰 검색 공간을 제시합니다. 이를 해결하기 위해 각 노드에 대한 최대 확장 한계를 설정했지만, 이는 모델이 지역 최적점에 갇히게 만들 수 있습니다. 둘째, 가치 모델은 검색 과정의 각 단계를 안내하기 때문에 생성 품질에 직접적인 영향을 미칩니다. 세분화된 가치 모델을 훈련시키는 것은 본질적으로 어려워, 모델이 반복적으로 향상되기 어렵게 만듭니다. AlphaGo의 핵심 성공은 점진적으로 성능을 향상시키기 위해 가치 모델을 훈련시키는 데 의존했지만, 토큰 생성의 복잡성으로 인해 우리의 설정에서는 이 원칙을 복제하기 어렵습니다.

결론적으로, MCTS는 사전 훈련된 가치 모델과 결합할 때 추론 중 성능을 향상시킬 수 있지만, 자가 검색을 통해 모델 성능을 반복적으로 향상시키는 것은 여전히 중요한 도전 과제로 남아 있습니다.5. 결론, 한계 및 향후 연구 (Conclusion, Limitation, and Future Work)

본 연구에서는 강화 학습(RL)을 통해 모델의 추론 능력을 향상시키는 여정을 공유했습니다. DeepSeek-R1-Zero는 초기 시작 데이터에 의존하지 않는 순수 RL 접근 방식을 대표하며, 다양한 과제에서 강력한 성능을 달성했습니다. DeepSeek-R1은 초기 시작 데이터와 반복적인 RL 미세 조정을 활용하여 더 강력한 성능을 발휘합니다. 궁극적으로, DeepSeek-R1은 다양한 과제에서 OpenAI-o1-1217과 동등한 성능을 달성합니다.

우리는 또한 추론 능력을 작은 밀집 모델로 증류하는 방법을 탐구했습니다. DeepSeek-R1을 교사 모델로 사용하여 80만 개의 데이터를 생성하고, 여러 작은 밀집 모델을 미세 조정했습니다. 그 결과는 유망합니다: DeepSeek-R1-Distill-Qwen-1.5B는 AIME에서 28.9%, MATH에서 83.9%로 GPT-4o와 Claude-3.5-Sonnet을 수학 벤치마크에서 능가했습니다. 다른 밀집 모델들도 동일한 기본 체크포인트를 기반으로 한 다른 지시 조정 모델들을 크게 능가하며 인상적인 결과를 달성했습니다.향후, 우리는 DeepSeek-R1에 대해 다음과 같은 방향으로 연구를 투자할 계획입니다:

– 일반 능력 (General Capability): 현재, DeepSeek-R1의 능력은 함수 호출, 다중 턴, 복잡한 역할 연기, JSON 출력과 같은 과제에서 DeepSeek-V3보다 부족합니다. 앞으로, 우리는 긴 CoT를 활용하여 이러한 분야의 과제를 향상시키는 방법을 탐구할 계획입니다.

– 언어 혼합 (Language Mixing): DeepSeek-R1은 현재 중국어와 영어에 최적화되어 있어, 다른 언어로 된 질의를 처리할 때 언어 혼합 문제가 발생할 수 있습니다. 예를 들어, DeepSeek-R1은 질의가 영어 또는 중국어가 아닌 다른 언어일지라도 추론과 응답에 영어를 사용할 수 있습니다. 우리는 향후 업데이트에서 이 한계를 해결할 계획입니다.

– 프롬프트 엔지니어링 (Prompting Engineering): DeepSeek-R1을 평가할 때, 우리는 프롬프트에 민감함을 관찰했습니다. few-shot 프롬프트는 일관되게 성능을 저하시킵니다. 따라서, 우리는 사용자에게 문제를 직접 설명하고 zero-shot 설정을 사용하여 출력 형식을 지정하도록 권장합니다.

– 소프트웨어 엔지니어링 과제 (Software Engineering Tasks): RL 과정의 효율성에 영향을 미치는 긴 평가 시간 때문에, 대규모 RL이 소프트웨어 엔지니어링 과제에 광범위하게 적용되지 않았습니다. 결과적으로, DeepSeek-R1은 소프트웨어 엔지니어링 벤치마크에서 DeepSeek-V3에 비해 큰 향상을 보이지 않았습니다. 향후 버전에서는 소프트웨어 엔지니어링 데이터에 대한 거부 샘플링을 구현하거나 RL 과정 중 비동기 평가를 통합하여 효율성을 향상시킬 계획입니다.

김성완님은 아래와 같이 위 논문을 요약합니다.

DeepSeek-R1-Zero: 사전 지도 미세 조정(SFT) 없이 대규모 강화학습(RL)으로 훈련된 모델로, 괄목할 만한 추론 능력을 보여줍니다. RL을 통해 자연스럽게 다양하고 강력한 추론 행동을 학습했지만, 가독성 저하 및 언어 혼합과 같은 문제점도 나타났습니다.

DeepSeek-R1: R1-Zero의 문제점을 해결하고 추론 성능을 더욱 향상시키기 위해 다단계 훈련 및 RL 이전의 콜드 스타트 데이터를 도입했습니다. OpenAI-o1-1217에 필적하는 추론 성능을 달성했습니다.

공개: 연구 커뮤니티 지원을 위해 DeepSeek-R1-Zero, DeepSeek-R1, 그리고 Qwen과 Llama 기반으로 DeepSeek-R1에서 추출한 6개의 밀집 모델(1.5B, 7B, 8B, 14B, 32B, 70B)을 오픈소스로 공개합니다.

핵심 기여:

사전 훈련: SFT 없이 기본 모델에 직접 RL을 적용하여 CoT(Chain-of-Thought)를 탐색하고 복잡한 문제를 해결하는 능력을 향상시켰습니다. 순수 RL만으로 LLM의 추론 능력을 향상시킬 수 있음을 증명한 첫 연구입니다.

추출(Distillation): 대형 모델의 추론 패턴을 소형 모델로 추출하여 소형 모델 자체 RL 학습보다 더 나은 성능을 달성했습니다. 오픈소스 DeepSeek-R1과 API는 향후 더 나은 소형 모델 추출에 도움이 될 것입니다.

소형 모델의 강화: DeepSeek-R1에서 생성된 추론 데이터를 사용하여 연구 커뮤니티에서 널리 사용되는 여러 밀집 모델을 미세 조정했습니다. 추출된 소형 밀집 모델은 벤치마크에서 매우 우수한 성능을 보였습니다. 특히 DeepSeek-R1-Distill-Qwen-7B는 AIME 2024에서 55.5%를 달성하여 QwQ-32B-Preview를 능가했습니다. DeepSeek-R1-Distill-Qwen-32B는 AIME 2024에서 72.6%, MATH-500에서 94.3%, LiveCodeBench에서 57.2%를 기록하며 이전 오픈소스 모델들을 크게 앞서고 o1-mini에 필적하는 성능을 보였습니다.

접근 방식:

DeepSeek-R1-Zero: SFT 없이 기본 모델에 직접 RL을 적용. 규칙 기반 보상 시스템(정확도, 형식)을 사용하여 GRPO(Group Relative Policy Optimization) 알고리즘으로 훈련. 자체 검증, 반성, 긴 CoT 생성 등 흥미로운 추론 행동이 자연스럽게 등장했지만 가독성 및 언어 혼합 문제 발생.

DeepSeek-R1: 콜드 스타트 데이터를 활용한 RL 적용.

콜드 스타트: 수천 개의 긴 CoT 예제로 모델을 미세 조정하여 초기 RL 행위자(actor)로 사용. 가독성 향상 및 잠재력 향상.

추론 지향 RL: 콜드 스타트 데이터로 미세 조정된 모델에 R1-Zero와 동일한 대규모 RL 훈련 적용. 언어 혼합 문제 완화를 위해 언어 일관성 보상 도입.

거부 샘플링 및 지도 미세 조정: RL 훈련에서 얻은 체크포인트를 사용하여 거부 샘플링을 통해 SFT 데이터 수집. 추론 데이터 외에도 쓰기, 사실 질의응답, 자기 인식 등 다양한 도메인의 데이터 포함.

모든 시나리오에 대한 RL: 모델의 유용성과 무해성을 향상시키면서 추론 능력을 개선하기 위해 2차 RL 단계 적용. 추론 데이터에는 규칙 기반 보상, 일반 데이터에는 보상 모델 사용.

추출: DeepSeek-R1의 추론 능력을 Qwen, Llama와 같은 소형 밀집 모델로 추출. 800k 샘플 데이터를 사용하여 SFT 적용. 단순 추출만으로도 소형 모델의 추론 능력이 크게 향상됨을 확인.

결론 및 향후 연구 방향:

DeepSeek-R1은 RL을 통해 모델 추론 능력을 향상시키는 데 성공했지만, 함수 호출, 다중 턴 대화, 복잡한 역할극, JSON 출력 등 일반적인 능력, 언어 혼합 문제, 프롬프트 엔지니어링, 소프트웨어 엔지니어링 작업 등에서 개선의 여지가 있습니다. 향후 연구에서는 이러한 부분에 집중하여 DeepSeek-R1의 성능을 더욱 발전시킬 계획입니다.

3.

양병찬님이 China’s cheap, open AI model DeepSeek thrills scientists의 일부를 번역하여 페이스북에 올렸습니다. 그중 일부입니다.

1. 도전 모델

R1은 중국에서 일고 있는 대형 언어 모델(LLM) 붐의 일부다. 헤지펀드에서 분사한 딥식은 지난달 저예산으로 구축되었음에도 불구하고 주요 경쟁업체를 능가하는 V3라는 챗봇을 출시하면서 비교적 듣보잡 상태에서 벗어났다. 전문가들은 딥식이 모델 훈련에 필요한 하드웨어를 임대하는 데 약 600만 달러가 소요됐을 것으로 추정하는 반면, 11배의 컴퓨팅 리소스를 사용한 메타(Meta)의 Llama 3.1 405B의 경우 6천만 달러 이상이 소요된 것으로 추정하고 있다.

딥식에 대한 소문 중 하나는, AI 처리를 위해 설계된 최고의 컴퓨터 칩에 대한 중국 기업의 접근을 제한하는 미국의 수출 규제에도 불구하고 R1을 만드는 데 성공했다는 것이다. “그게 중국에서 나왔다는 사실은 ‘컴퓨팅 규모’보다 ‘자원의 효율성’이 더 중요하다는 것을 보여준다”라고 워싱턴주 시애틀의 AI 연구원 프랑수아 콜레(François Chollet)는 말한다.

워싱턴주 벨뷰의 기술 전문가이자 대만에 본사를 둔 몰입형 기술 회사 HTC에서 일하는 앨빈 왕 그레이린(Alvin Wang Graylin)은 X에 다음과 같이 썼다. “딥식의 발전은 한때 미국이 차지했던 것으로 여겨지는 선두권과의 격차가 상당히 좁아졌음을 시사한다. 양국(兩國)은 현재의 승산 없는 군비 경쟁 방식을 계속하는 대신 고급 AI 구축을 위한 협력적 접근 방식을 추구해야 한다.”2. 사고(思考)의 사슬

LLM은 수십억 개의 텍스트 샘플을 학습하여 ‘토큰’이라는 단어 부분으로 잘라내고 데이터에서 패턴을 학습한다. 이러한 연관성을 통해 모델은 문장의 후속 토큰을 예측할 수 있다. 그러나 LLM은 ‘환각(hallucination)’이라는 현상을 통해 사실을 만들어내는 경향이 있으며(https://www.nature.com/articles/d41586-025-00068-5), 문제를 추론하는 데 어려움을 겪는 경우가 많다.

o1과 마찬가지로, R1은 ‘사고의 사슬(chain of thought)’ 방법을 사용하여 더 복잡한 작업(예: 때때로 접근 방식을 역추적하고 평가함)을 해결하는 LLM의 능력을 향상시킨다. 딥식은 강화 학습(reinforcement learning)을 통해 V3를 ‘미세 조정’함으로써 R1을 만들었는데, 이는 모델이 ‘정답에 도달하는 것’과 ‘사고를 설명하는 방식으로 문제를 해결하는 것’에 대해 보상을 제공했다.

“딥식은 컴퓨팅 성능이 제한되어 있었기 때문에 알고리즘적으로 혁신할 수 있었다”라고 영국 에든버러 대학교의 AI 연구원 웬다 리(Wenda Li)는 말한다. 강화 학습을 하는 동안, 연구팀은 각 단계에서 모델의 진행 상황을 추정하는 대신 별도의 네트워크를 사용하여 평가했다. 이는 훈련 및 운영 비용을 줄이는 데 도움이 되었다고 영국 케임브리지 대학교의 컴퓨터 과학자 마테야 잠닉(Mateja Jamnik)은 말한다. 연구진은 또한 모델이 각 작업과 관련된 부분만 활성화할 수 있는 ‘전문가 혼합(mixture-of-experts)’ 아키텍처를 사용했다.모델과 함께 제공되는 기술 논문(https://huggingface.co/deepseek-ai/DeepSeek-R1)에 보고된 벤치마크 테스트에서, 딥식-R1은 UC 버클리의 연구진이 만든 수학 문제 세트 MATH-500에서 97.3%를 기록했으며, Codeforces 대회에서 인간 참가자의 96.3%보다 우수한 성적을 거두었다. 이는 o1의 능력과 대등한 수준이며, o3는 비교 대상에 포함되지 않았다(아래 댓글의 ‘AI 라이벌’ 참조).

벤치마크가 모델의 진정한 추론 또는 일반화 능력을 포착하는지, 아니면 단순히 그러한 테스트를 통과하기 위한 것인지는 알기 어렵다. 하지만 R1은 개방되어 있기 때문에 연구자들이 그 사고의 사슬에 접근할 수 있다고 케임브리지 대학의 컴퓨터 과학자 마르코 도스 산토스(Marco Dos Santos)는 말한다. “이를 통해 모델의 추론 과정을 더 잘 해석할 수 있다”라고 그는 말한다.

이미 과학자들은 R1의 능력을 테스트하고 있다. 크렌은 두 경쟁 모델에 3,000개의 연구 아이디어를 얼마나 흥미로운지에 따라 분류하도록 하고 그 결과를 사람이 만든 순위와 비교했다. 이 측정에서 R1은 o1에 비해 약간 저조한 성적을 보였다. 하지만 R1은 양자 광학의 특정 계산에서 o1을 앞섰다고 크렌은 말한다. “이는 매우 인상적인 결과다”라고 그는 말한다.

4.

이진원님이 페이스북에 올린 글입니다. DeepSeek-R1은 진짜로 가성비 모델인가?라는 주제입니다.

이제 진실이 무엇인지는 별로 중요하지 않을 만큼 DeepSeek은 이미 성공한 모델이 되어버린 것 같지만… 제가 생각하는 바를 정리해서 적어봅니다. DeepSeek-R1이 발표된 이후 Nvidia 주가가 20%가까이 폭락하고, 다른 빅테크 기업들의 주가도 줄줄이 폭락한 것을 보면 이제 엄청나게 많은 GPU와 computing power를 앞세우지 않아도 좋은 모델을 만들 수 있다. 그래서 빅테크들만의 영역이었던 foundation model을 누구나 만들 수 있을 거다. 라는 의미로 받아들이는 것 같은데요… 하나씩 짚어보겠습니다 (일부 잘못된 내용이 있을 수도 있습니다)

1. 우선 가성비가 좋다는 말이 훈련에서의 가성비인지 추론 혹은 서비스에서의 가성비인지를 명확히 해야할 필요가 있습니다. 지금까지 나오는 내용을 정리해보면 DeepSeek이 H800 GPU로 557.6만달러(약 80억원)로 학습을 했다는 게 제일 화제가 되고 있고(그림1), API 비용도 o1 대비해서 1/10 이하로 서비스 하고 있다는 사실(그림2)도 주목받고 있습니다.

2.학습부터 생각해보겠습니다. 이것도 두가지로 나눠서 생각해볼 수 있는데, 첫번째는 학습비용이 80억밖에(?) 안들었다는 모델은 이번에 화제가 된 DeepSeek-R1이 아니고 DeepSeek-V3입니다. 그럼 R1은 학습하는데 얼마가 들었을까요? 그건 알 수 없지만 R1은 DeepSeek-V3가 있다는 전제 하에서 시작됩니다 그러니까 일단 V3를 학습하는 비용이 들고 거기에 추가로 비용이 듭니다. R1을 어떻게 학습했는지 technical report를 살펴보면, 1) 우선 V3를 가지고 GPRO라는 방법으로 강화학습을 통해서 reasoning을 할 수 있도록 학습합니다. 이 모델이 DeepSeek-R1-Zero 입니다. 2) 이제 DeepSeek-R1-Zero를 가지고 reasoning을 학습할 CoT(Chain of Thought) data를 생성해낸 다음 사람들이 붙어서 데이터를 열심히 가공합니다. 그리고 이 data를 이용해서 SFT(Supervised Fine-Tuning)으로 DeepSeek-V3-base 모델을 학습합니다(cold start) 3) 이렇게 학습된 모델을 다시 1)에서 한 것과 같은 방식으로 강화학습을 통해서 reasoning을 잘 할 수 있도록 학습시킵니다. 4) 3)에서 학습할 때 사용한 checkpoint를 이용하여 reasoning data(60k)를 생성하고, DeepSeek-V3를 학습할 때 썼던 SFT data등을 활용하여 non-reasoning data(20k)를 만든 다음 또 SFT로 학습합니다. 5) 마지막으로 강화학습을 사용하여 helpfulness와 harmlessness를 향상시키고 추론능력을 정교화하게됩니다. 굉장히 복잡하지요? H800으로 80억 들여서 학습한 이후에 이렇게 많은 과정을 추가로 학습해야 DeepSeek-R1이 만들어집니다. 이게 진짜 비용 효율적인 학습인가요? 어차피 상대적인 비교라서 제가 맞다 틀리다 얘기할 수는 없지만, 사람들이 얘기하는 것보다는 훨씬 더 많은 비용이 들어갔다는 걸 알 수 있습니다.

3.그럼에도 불구하고 작년에 나온 DeepSeek-V3도 충분히 좋은 모델이긴 합니다. 그럼 이거라도 적은 비용 들여서 학습했으면 좋은거 아니냐? 라고 생각할 수 있겠죠. 그런데 이 부분도 다시 생각해봐야할 것은 1회 학습하는데 드는 비용이 적다고 해서 실제로 이 모델을 만들어내는데 들어간 비용이 적다고는 할 수 없기 때문입니다. 한방에 학습이 잘 된다면 80억으로 가능할 수 있지만, 좋은 결과를 위해서는 당연히 여러번의 시행착오가 있어야 하고 최고의 학습 레시피를 찾아내는 과정이 필요합니다. 이 과정에서 얼마나 많은 GPU와 computing power가 사용되었는지는 아무도 모릅니다. 실제로 DeepSeek에 H100이 5만대 있다는 얘기도 있구요… 아마도 엄청난 비용을 들여서 학습하는 과정이 있었을 거라고 생각합니다. 하지만 1회 학습하는데 드는 비용을 줄인 것 자체는 훌륭한 업적이라고 생각합니다. 제가 걱정하는 건 이제 우리도 80억 있으면 이런거 만들 수 있겠네라고 생각하는 사람들이 많아지는 것입니다.

4. 이제 추론(서비스)로 넘어가볼까요? 사실 추론 서비스에서 비용이 실제로 얼마나 드는지는 API 가격으로 판단하기 쉽지 않습니다. 회사마다 이윤이 차지하는 비율이 다르고, 또 어떤 회사는 손해를 감수하면서까지 시장점유율 등을 위해서 서비스를 할 수 있기 때문이죠. 실제로 together.ai에 가보시면 현재 다양한 오픈모델들을 서비스 하고 있는데, (그림3)에서 보시는 것처럼 DeepSeek-R1은 가격이 매우매우 비쌉니다. LLaMA 405B 모델보다 2배 비싼 가격으로 서비스 되고 있습니다. 한 회사에서 여러개의 모델을 서빙하고 있다면 모델별로 이윤을 비슷하게 남길 가능성이 높고 그렇다면 이 비용이 더 실제 비용과 가깝다고 생각하는게 타당하지 않을까요?

5. DeepSeek-R1이 싸게 서빙할 수 있는 이유로 (잘못)알려진 것 중 대표적인 것이 MoE(Mixture of Expert) 구조를 가지고 있다는 것입니다. DeepSeek model은 671B의 파라미터를 가지고 있는데 그 중에 1번의 inference에서는 37B만 활성화된다고 합니다. 그런데 클라우드에서 다양한 request를 받아서 동시에 처리하는 경우에는 결국 671B 전체를 여러대의 GPU에 나눠서 다 가지고 있어야 합니다. 각 request마다 사용하는 expert가 다 다르기 때문입니다. 더군다나 expert들이 GPU 여러개에 흩어져 있게 되기 때문에, GPU간에 data를 주고받아야 하는 일들이 더 많아지게 됩니다. 따라서 MoE 구조 자체는 추론(inference)에 상대적으로 비효율적인 구조를 가지고 있습니다. 그리고 이런 이유로 상대적인 추론 속도(tokens/sec)도 매우 느려질 수밖에 없습니다. (그림4)를 보시면 R1이 o1 대비해서 추론 속도가 40%이상 느린 것을 볼 수 있습니다.

6. 결론적으로 학습이든 추론이든 가성비가 좋은 모델인가에 대한 질문에 저는 그렇지 않다고 생각합니다. 하지만 그렇다고 DeepSeek을 평가절하할 필요는 없다고 생각합니다. 성능이 좋은 모델인 건 확실하고, 이런 모델들이 오픈되었다는 것은 큰 의미가 있다고 생각합니다.

7. 마지막으로 엄밀하게 말해서 DeepSeek은 오픈소스는 아니고 오픈모델입니다(weight만 공개, 학습데이터나 레시피는 공개하지 않음). 그래서 이제 누구나 이런 모델을 쉽게 만들 수 있느냐는 질문에는 아니라고 할 수 있을 것 같습니다. 위에 학습 방법을 간단하게 정리한 부분에서도 알 수 있다시피 technical report에 자세히 적히지 않은 수많은 내용이 있을 것이고, 공개된 내용만으로도 수많은 노력과 노하우가 필요하기 때문입니다. DeepSeek-R1은 openAI의 o1 모델이 어떻게 reasoning을 잘하는지에 대해서 모두가 궁금해했던 부분에 대한 답을 어느정도 알려줬고, 누군가는 이러한 방법을 이용해서 비슷하거나 더 나은 모델을 만들어낼 수 있는 발판을 마련해줬다고 생각합니다. 앞으로도 DeepSeek과 같은 회사들이 많이 나오기를 기대해봅니다.

참고로 Deepseek가 구현한 3FS라는 분산파일시스템을 소개하는 글입니다.